- 使用 deepseek API + ChatNio

- 使用开源项目deepseek-free-api + ChatNio

- 腾讯 Cloud Studio 部署 DeepSeek-R1:14B

- 解决卡顿问题,其它渠道使用DeepSeek

在NAS 上部署的方式

方案一:API + ChatNio

❌ 缺点:API现阶段无法充值,返回的数据较大会出现无相应情况。

需要准备:

- ChatNio。(也可以选择其它

LLM平台:ChatGPT Next Web、BotGem、OpenCat或者LobeChat等) - 注册deepseek开放平台,并创建

API key。

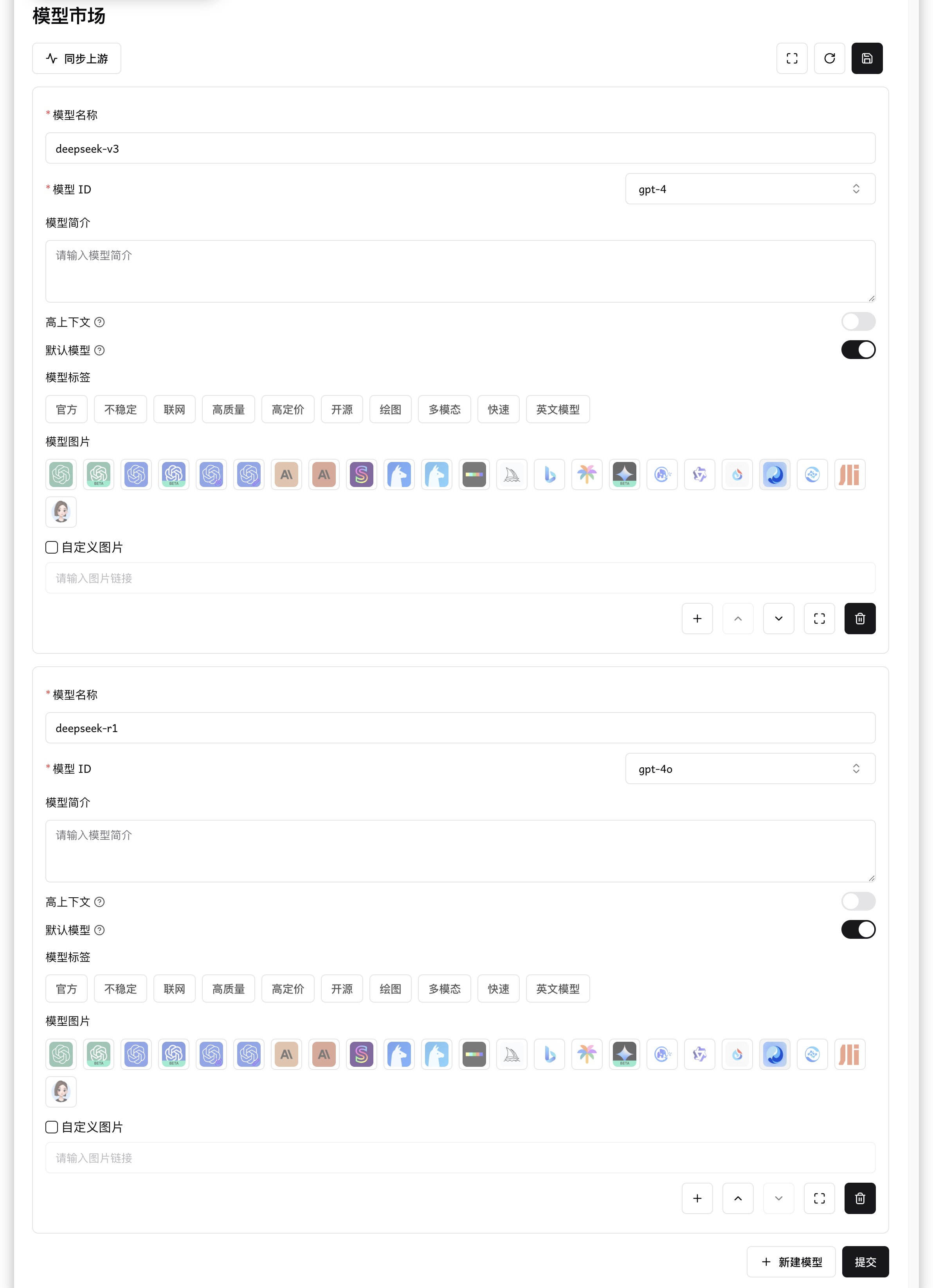

ChatNio 配置

- 渠道设置 : 在渠道设置中,配置一下 密匙、接口地址、映射关系;

2. 模型市场 : 在模型市场中,对刚才渠道中的创建的模型进行上架操作;

2. 模型市场 : 在模型市场中,对刚才渠道中的创建的模型进行上架操作;

deepseek-api 映射模型

-

deepseek-chat模型已全面升级为 DeepSeek-V3,接口不变。 通过指定model='deepseek-chat'即可调用 DeepSeek-V3。 -

deepseek-reasoner是 DeepSeek 最新推出的推理模型 DeepSeek-R1。通过指定model='deepseek-reasoner',即可调用 DeepSeek-R1。

方案二:网页封装 + ChatNio

❌ 缺点: 网页中有的问题他都有。就比如:

服务器繁忙,请稍后再试。

需要准备:

- deepseek-free-api

- ChatNio

deepseek-free-api 安装和配置

-

在NAS中下载并启动

deepseek-free-api容器,在配置容器时,环境这里加一条deepseek的token信息(📢 注意:token可加可不加,加上后,提问和回答可以同步到网页版)

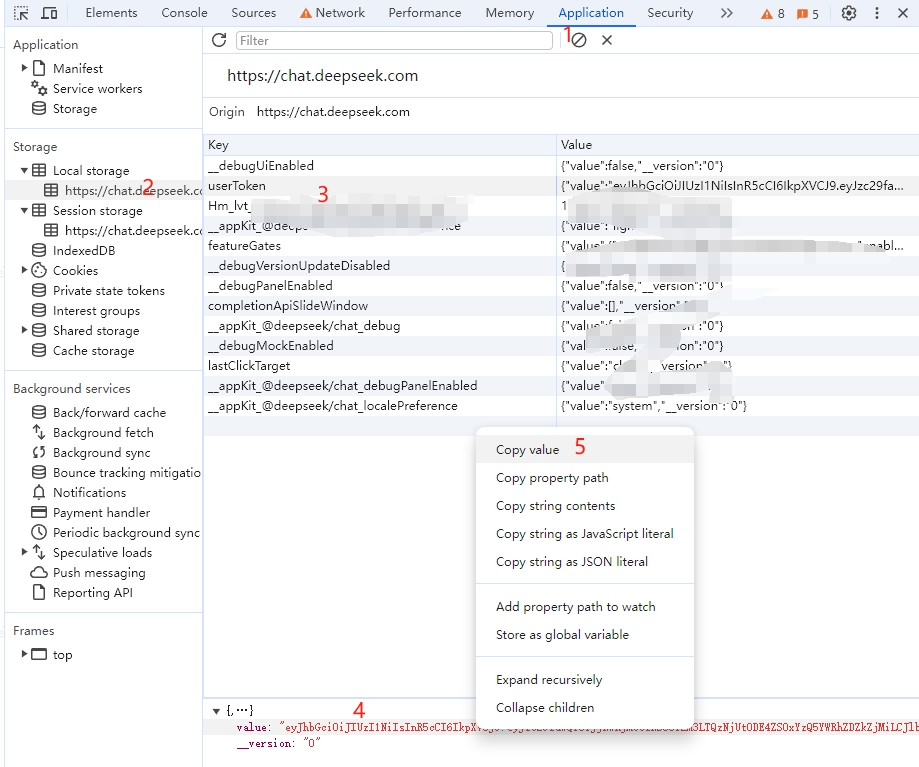

-

token获取方式:打开浏览器 -> 登录 deepseek -> ctrl+F12 打开

开发者模式-> 在application模块中找到userToken-> 复制其中的value下的内容

ChatNio 配置

基本和 deepseek-api 的配置相同,修改一下 秘钥、接入点、模型映射 即可

deepseek-free-api 映射模型

- 默认deepseek-V3:

deepseek - 深度思考:

deepseek-think或deepseek-r1 - 联网搜索:

deepseek-search - 深度思考 + 联网搜索:

deepseek-r1-search或deepseek-think-search - 静默模式(不输出思考过程或联网搜索结果):

deepseek-think-silent或deepseek-r1-silent或deepseek-search-silent

方案三:使用云端部署

腾讯 Cloud Studio 部署 DeepSeek-R1:14B 模型,参考文章

部署完成后,还需要进行内网穿透,比如:frp

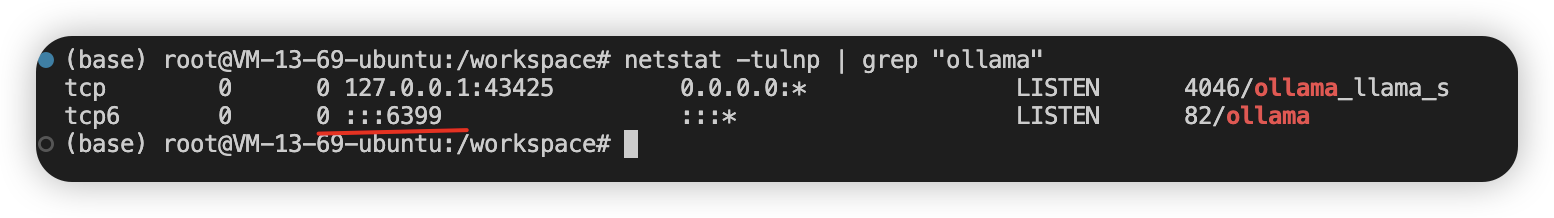

📢 需要注意:做端口映射的时候,端口号可能并不是常见的 11434,需要使用如下命令查看一下

ChatNio渠道配置的时候

- 密钥填写:<>

- 接入点:http://公网地址:映射端口,例如:http://xxx.xxx.xxx.xxx:6034

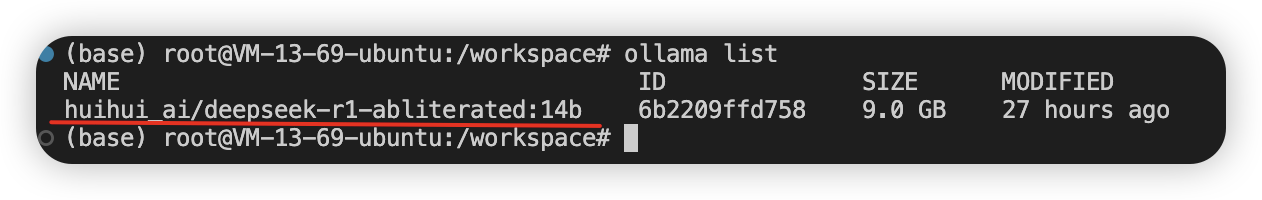

- 模型映射:填写 ollama list 查询出来的名称,比如我这里就是:

huihui_ai/deepseek-r1-abliterated:14b

附录:deepseek 的一些知识

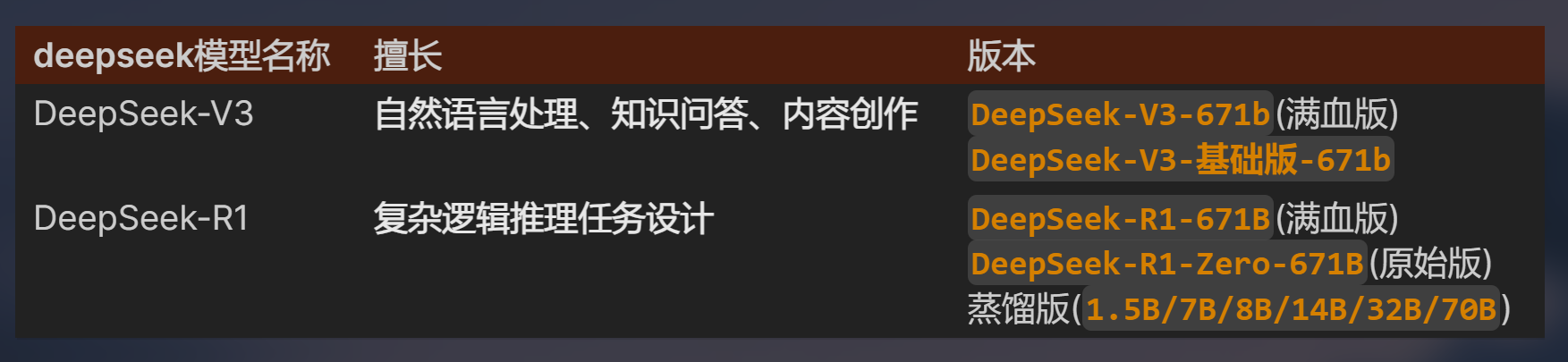

| deepseek模型名称 | 擅长 | 版本 |

|---|---|---|

| DeepSeek-V3 | 自然语言处理、知识问答、内容创作 | DeepSeek-V3-671b(满血版)DeepSeek-V3-基础版-671b |

| DeepSeek-R1 | 复杂逻辑推理任务设计 | DeepSeek-R1-671B(满血版)DeepSeek-R1-Zero-671B(原始版)蒸馏版( 1.5B/7B/8B/14B/32B/70B) |

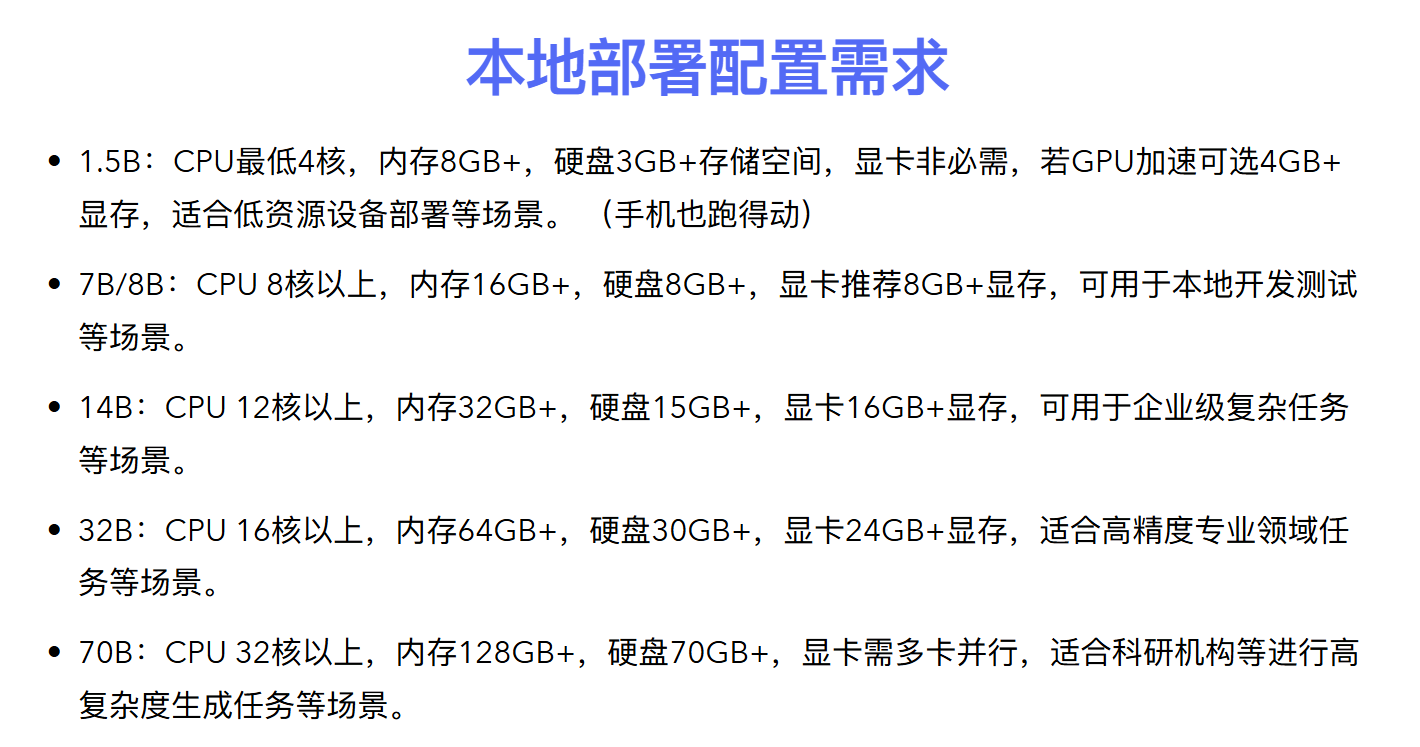

| 模型参数规模 | CPU 建议 | GPU 建议 | 内存建议 | 磁盘空间建议 | 适用场景 |

|---|---|---|---|---|---|

| 1.5b (15亿) | 4核+ | 核显独显均可 | 8GB | 10GB 以上 SSD | 小型 NLP 任务、文本生成、简单分类 |

| 7b (70亿) | 6核+ | 显存8GB+ | 16GB | 20GB 以上 SSD | 中等规模 NLP、对话系统、文本分析 |

| 14b (140亿) | 8核+ | 显存12GB+ | 32GB | 50GB 以上 SSD | 复杂 NLP、多轮对话、知识问答 |

| 32b (320亿) | 12核+ | 显存16GB | 64GB | 100GB 以上 SSD | 大规模 NLP、多模态任务、研究用途 |

| 70b (700亿) | 16核+ | 需多GPU并行 显存40GB+ | 128GB | 200GB 以上 SSD | 超大规模模型、研究、企业级应用 |

| 671b (6710亿) | 服务器级 CPU | 需多GPU并行 显存320GB+ | 256GB | 1TB 以上 NVMe SSD | 超大规模训练、企业级 AI 平台 |

671b- 又被成为满血版,其他版本均为 蒸馏版DeepSeek-R1-671B: 满血版。DeepSeek-R1-Zero-671B: R1的原始版本,会犯错,但更有创意。 基于千问再训练模型:DeepSeek-R1-Distill-Qwen-1.5B、DeepSeek-R1-Distill-Qwen-7B、DeepSeek-R1-Distill-Qwen-14B、DeepSeek-R1-Distill-Qwen-32B。 基于Lama再训练模型:DeepSeek-R1-Distill-Llama-8B、DeepSeek-R1-Distill-Llama-70B。

因你更精彩

打赏将用于网站日常运营